Techniques et méthodes d’analyse du comportement non-verbal

Pour effectuer une analyse professionnelle du comportement non-verbal, il est crucial d’utiliser des techniques qui permettent de décrire objectivement le comportement et de lui attribuer une signification fiable. Les principaux avantages reconnus par l’analyse scientifique de la communication non-verbale sont:

- Identifier avec précision les émotions et les humeurs des autres

- Anticiper le comportement de la personne analysée

- Démasquer les mensonges avec l’intégration de l’analyse verbale avec celle des expressions faciales

- Identifier les forces et les faiblesses de l’interlocuteur et dans la relation interpersonnelle.

Il est possible d’apprendre les techniques d’analyse non-verbale rapidement, en suivant une formation ciblée qui utilise une didactique interactive et basée sur des exercices pratiques.

Les bases scientifiques

Un premier essai scientifique sur les expressions émotionnelles est le livre du neurologue français Guillaume Benjamin Amand Duchenne de Boulogne, intitulé, Mécanisme de la physionomie humaine, ou Analyse électro-physiologique de l’expression des passions applicable à la pratique des arts plastiques. Écrit en 1862, il reporte la méthode d’application des électrodes sur les muscles du visage pour établir la relation entre les mouvements faciaux et les expressions émotionnelles relatives. Même aujourd’hui, en l’honneur du savant français, le sourire de la joie authentique est définit comme sourire Duchenne.

Par la suite, en 1872, Charles Darwin a écrit l’essai L’Expression des émotions chez l’homme et d’autres animaux où il suppose que les émotions sont innées, car elles sont un produit de l’évolution. À telles émotions correspondent des expressions faciales et corporelles qui sont les mêmes soit chez les hommes d’origine ethnique différente, soit chez les primates non humains ou d’autres animaux. Les études sur les expressions faciales de Darwin, cependant, ne continuent pas après sa mort à cause de l’hostilité du milieu scientifique envers lui et ses théories; il est en effet critiqué pour avoir attribué aux animaux des sentiments qui appartiennent, selon ses détracteurs, seulement à l’homme, et pour s’être basé sur l’observation directe.

Les conceptions sur l’universalité des expressions émotionnelles de base commencent à intéresser de nouveau les scientifiques dans la seconde moitié des années ‘50. D’éminents chercheurs tels que Friesen, Ellsworth, Ekman, Izard, Birdwhistell, pour n’en citer que quelques-uns, cherchent à en démontrer la validité. Ils développent un ensemble de théories,méthodes et preuves qui, dans leur ensemble, constituent le soi-disant Programme de l’Expression Faciale.

Ces chercheurs pensent qu’à l’origine de l’expression des émotions et de l’expérience émotionnelle, il y a un nombre précis de programmes neurophysiologiques innés. Il existe donc un parcours spécifique pour chaque émotion qui garantit l’invariance des expressions faciales associées à chaque émotion. Les programmes neuraux innés, phylogénétiquement hérédités, donnent lieu à des réponses adaptatives attribuables aux familles émotionnelles.

Selon la théorie de l’évolution, qui comprend ces travaux, les émotions ont une fonction adaptative, permettant aux individus de réagir avec une réponse immédiate à des stimuli internes, externes, naturels ou acquis, leur accordant de cette manière de survivre.

Les techniques d’analyse non-verbale sont divisées en deux groupes:

- techniques de codage, c’est à dire la description des mouvements du visage et du corps;

- techniques de décodage qui fournissent l’interprétation du mouvement.

Techniques d’analyse scientifique des expressions du visage

Interpretative System of Facial Expressions (ISFE)

Avec le Interpretative System of Facial Expressions (ISFE) élaboré en 2013 par Jasna Legiša dans le laboratoire NeuroComScience, on obtient un tableau synoptique pour la signification des mouvements faciaux. Il s’agit d’une série de tableaux et de descriptions qui intègrent et rangent les actions du visage aux émotions. Les indications sont prises à partir de systèmes antérieurs et de la littérature existante sur le sujet.

En plus des expressions émotionnelles primaires et secondaires, d’autres signaux du visage sont également décrits: les manipulateurs, les illustrateurs et les régulateurs. D’abord, les expressions émotionnelles sont regroupées dans ce qu’on appelle les grandes familles comme suggéré par Hjorstjo (1969), Izard (1979) et Ekman (1983).

À chaque famille appartiennent plusieurs expressions faciales qui, malgré les différentes nuances de signification, sont unies par le fait de recevoir le même emplacement émotionnel. Par exemple, dans la famille de la surprise font partie la surprise sincère, celle simulée, celle ennuyée, l’étonnement, et ainsi de suite. Dans les tableaux ISFE, les mouvements des émotions primaires ont été divisés en 3 catégories:

- dans la catégorie 1, il y a les mouvements musculaires qui appartiennent à une catégorie émotionnelle;

- dans la catégorie 2, sont placés ces mouvements qui peuvent appartenir à deux ou trois familles d’émotions primaires;

- dans la catégorie 3, on retrouve des variantes mineures des expressions émotionnelles, c’est-à-dire les mouvements qui font partie de nombreuses familles émotionnelles. Cette distinction en catégories facilite la précision de l’interprétation et donc de l’ensemble de l’analyse.

Méthode Hjortsjö: Man’s Face and Mimic Language

Ceci est le premier traitement systématique des actions spécifiques des muscles faciaux et de leurs significations émotionnelles regroupées en 8 familles d’émotions. Il est élaboré en 1969 par Hjortsjö, professeur d’anatomie à l’Université de Lund en Suède. Dans son manuel on retrouve le codage et le décodage des expressions faciales avec lequel il est possible de déterminer les contractions des muscles du visage, individuellement ou en combinaison. Les études principales précédant Hjortsjö sont réalisées par Landis (1924), Frôis-Wittman (1930) et Fulcher (1942), qui sont beaucoup moins complètes.

Maximally Discriminative Coding System (MAX)

Si jusqu’à présent les outils de codage ont été décrits dont l’objectif était de décrire tous les mouvements musculaires faciaux, quelle que soit la connaissance de la signification de ces actions, dans cet autre instrument on identifie seulement les unités comportementales des mouvements auxquels les auteurs attribuent une signification.

Le Maximally Discriminative Coding System (MAX), développé par Izard en 1979, et AFFEX, développé en 1983, qui est une deuxième version de MAX, réalisé non seulement par Izard mais aussi par Dougherty et Hembree, établissent a priori les configurations faciales en les étiquetant sur la base des expressions du visage typiques des émotions de colère, de tristesse, de peur, d’intérêt, de joie, de surprise, de douleur, de dégoût et de honte. En pratique, chaque expression prototypique est classifiée pour chaque émotion.

Les émotions considérées sont le dégoût, la colère, la surprise, la peur, la tristesse, la joie, l’intérêt, la douleur et la honte.

Emotion FACS (EMFACS) et Facial Action Coding System Affect Interpretation Dictionary (FACSAID)

Ekman et Friesen décrivent les significations d’interprétation des UA (Unités d’Action) du FACS, en décrivant les expressions de 6 familles d’émotions: joie, tristesse, dégoût, colère, surprise et peur. Ce travail, réalisé dans les années 80, est appelé Emotional FACS (EMFACS). Depuis 1994, Hager travaille auprès du laboratoire d’Ekman et il étudie les techniques de reconnaissance automatique informatisée des actions faciales. Une base de données avec une nouvelle interface a été développée, créant ainsi un système appelé FACS Affect Interpretation Dictionary ou FACSAID.

Hanest

Dans la même année où sort la première version du Facial Action Coding System, en 1978, le Manuel HANEST également est publié, élaboré par deux chercheurs français, Ermiane et Gergerian, ayant le même but du FACS c’est-à-dire de décrire les mouvements faciaux.

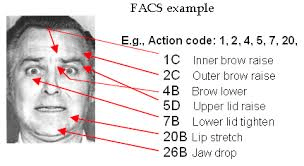

Facial Action Coding System

En 1978, Paul Ekman et Vincent W. Friesen introduisent le Facial Action Coding System (FACS) et en 2002 la deuxième version est publiée avec Joseph Hager. C’est un système descriptif, donc de codage facial, et donc il n’attribue des significations aux expressions faciales. Il s’agit d’une description détaillée des changements d’aspect dus aux contractions du visage

Il s’agit de la même structure du système de codage pour les adultes mais spécifiquement utilisée pour les nouveau-nés et les jeunes enfants. Oster (1993) prend en compte les particularités du visage et ajuste les descriptions. Le BabyFACS est purement descriptif des changements d’aspect des mouvements faciaux, sans y attribuer des significations d’interprétation.

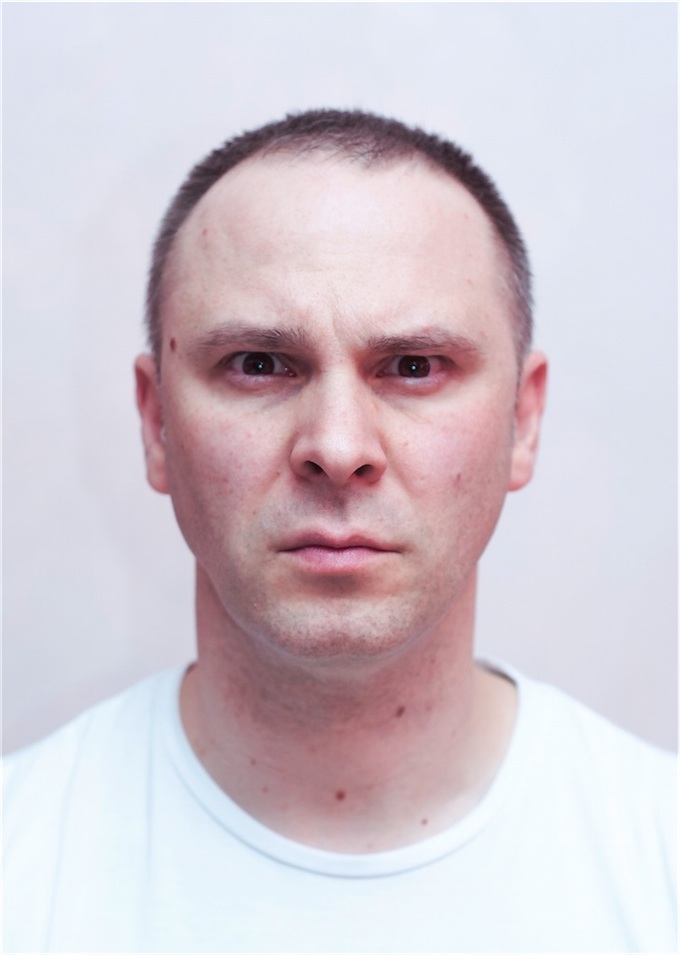

Exemple simple de configuration de codage et de décodage des expressions faciales (EXEMPLE PHOTO)

Alcune Azioni di base del volto superiore

Alcune Azioni di base del volto superiore

| 1 – soulever la partie interne des sourcils |  |

| 2 – soulever la partie externe des sourcils |  |

| 4 – baisser et rapprocher les sourcils |  |

| 5 – écarquiller les yeux |  |

| 6 – lever les joues |  |

| 7 – tension des paupières |  |

| Quelques combinaisons du visage | |

| 1 + 2 + 4 (ou 3, selon certaines techniques de codage) Il s’agit du prototype de la PEUR. Dans aucune autre émotion primaire une telle combinaison se produit. |  |

| 4 + 5 correspond à la combinaison prototypique du visage supérieur de la colère. |  |

Techniques d’analyse scientifique des gestes et de la posture

Body Coding System

C’est un système de codage et de décodage du comportement moteur-gestuel et postural pour l’analyse de la communication non-verbale, développé par Jasna Legiša. Le système de Body Coding System analyse les expressions non-verbales du corps en les décomposant en unité d’action en vue d’une classification qui permet la lecture des émotions d’une personne.

Le Body Coding System est basé sur l’observation des changements momentanés d’aspect du corps en raison de l’activité musculaire. La technique de mesure du comportement moteur-gestuel et postural est née pour répondre à des questions sur les liens existants entre les expressions du corps et l’expérience émotionnelle ainsi que les processus de communication. Par conséquent, les objectifs du Body Coding System sont:

- ADOPTER une approche structurée pour l’analyse du comportement moteur-gestuel et postural

- DÉFINIR la structure des mouvements et leur classification

- ASSOCIER les mouvements et les postures à des significations émotionnelles, culturelles et de conversation.

L’examen est une étape importante pour l’utilisation de la technique du Body Coding System pour être ainsi certifiés d’être en mesure d’appliquer l’instrument. Il est recommandé de participer à l’examen final après avoir fait beaucoup de pratique dans l’analyse du comportement moteur-gestuel puisqu’une lecture superficielle du manuel ne suffit pas. Pour réussir l’examen, il est nécessaire d’avoir une bonne maîtrise des unités d’action du corps et de les reconnaître le plus rapidement possible. Notre équipe sera toujours disponible pour toute question ou préoccupation justement pour vous aider et vous accompagner dans l’apprentissage.

Le jury d’examen, qui certifie la connaissance du système de codage moteur-gestuel et postural Body Coding System, sera composé de deux ou plus codeurs experts en BCS et d’analystes du comportement émotionnel du visage et du corps indiqués par le laboratoire d’analyse comportementale de NeuroComScience.

The Body Action and Posture coding system

The Body Action and Posture coding system (B.A.P.; Dael, N., Mortillaro, M., & Scherer, 2012), est un système de codage du comportement moteur-gestuel et postural qui tient en compte les diverses parties du corps. Le Body Action and Posture Coding System étudie principalement les différences de changement entre l’action et la posture. Selon les auteurs, les actions sont des unités de mouvement du corps qui sont séparées et ne faisant pas partie de la classification du corps. Une unité d’action du corps est une déviation locale d’un ou d’un groupe d’articulateurs (tête, tronc, bras, main) à l’extérieur d’une configuration posturale précédente mais qui ensuite retourne toujours à la configuration précédente ou à une autre. (p.ex. tête secouante, geste de pointer un doigt).

Contrairement aux unités de posture, les unités d’action apparaissent et changent plus fréquemment, ont un début très discret (point de départ), une durée relativement brève et une fin distincte (point final). Ces actions corporelles sont effectuées par la tête, les épaules, le tronc, les bras (coudes) et les jambes (genoux) impliquant des activités telles que baisser la tête, hausser les épaules, gesticuler, égratigner, donner des coups de pied, etc. Le début d’une unité d’action correspond au moment où le sujet change sa position actuelle de repos. La fin d’une unité d’action correspond au moment où le sujet retourne dans une position (de repos) (celle initiale ou une nouvelle position).

Le Body Action and Posture coding system subdivise la recherche en Phase de Transition et en Phase de Configuration, celles ci étant toujours liées pour la réalisation d’une posture. La transition initiale est le point de départ du mouvement nécessaire pour atteindre la position finale, ou le photogramme initial de la vidéo. La transition correspond au moment où la transition décrite dans une catégorie particulière est terminée ou au dernier photogramme de la vidéo si le mouvement compromis est coupé de la vidéo. Le photogramme est codé comme le début de la configuration de la posture. Pas toutes les actions du comportement n’interrompent une position en cours. Par conséquent, il est possible qu’une position d’une partie du corps (par exemple, la tête en avant) ne soit pas cassée par l’action d’une autre partie du corps (secouer la tête de côté). Au cours de la phase de configuration, la position finale codée du sujet est maintenue pour la direction codée. Cela ne signifie pas que la posture obtenue soit statique.

Dans le Body Action and Posture coding system les postures sont différentes des actions parce que:

- Les postures sont moins sujettes à des changements fréquents et ont donc une durée plus longue;

- Les postures sont robustes (des petits mouvements ne changent et ne déforment pas la posture)

- Tenant compte que les actions peuvent ou ne peuvent pas être montrées, le corps est constamment dans un ou l’autre alignement postural.

Cela signifie que quand une partie du corps ne participe pas à une action, elle est toujours dans une posture particulière.

An Annotation Scheme for Conversational Gestures: How to economically capture timing and form

Un autre système de codage du comportement moteur-gestuel a été développé par Kipp et al. (2007) décrit dans An Annotation Scheme for Conversational Gestures: How to economically capture timing and form (Kipp et al 2007). Leur but est de fournir des bonnes annotations sur les gestes qu’une personne fait, pour clarifier la signification des gestes produits au cours d’une conversation, en essayant de donner une explication universelle de ces mouvements. Ils étudient principalement les bras et les mains en ne considérant pas le reste du corps. Ils effectuent une recherche principalement sur la mesure de la hauteur, la distance, le type d’orientation radiale, la trajectoire des bras et des mains, mais ici aussi ils manquent des mouvements complexes ainsi que la description de tous les mouvements qui peuvent être exécutés par le corps. Neuroges (NGS) system décrit les gestes en 3 modules, surtout en tenant compte des mouvements des mains:

- cinétisme gestuel,

- encodage relationnel bimanuel et

- codage des fonctions gestuelles.

Le premier module se réfère aux caractéristiques des mouvements de la main: mouvement versus aucun mouvement, trajectoire du mouvement, dynamisme (c’est-à-dire le temps). Le second module se réfère à la relation entre les deux mains, la relation spatiale et la fonction relationnelle. Le troisième module se réfère à la fonction et à la classification des gestes.