Methoden und Techniken der nonverbalen Verhaltensanalyse

Um eine professionelle nonverbale Verhaltensanalyse durchzuführen, ist es von grundlegender Bedeutung Techniken zu verwenden, die es erlauben, das Verhalten objektiv und glaubwürdig zu beschreiben. Die Hauptvorteile der wissenschaftlichen Analyse der nonverbalen Kommunikation sind:

- die Emotionen und Geisteszustände anderer Personen mit Genauigkeit zu erkennen,

- das Verhalten von Menschen zu antizipieren,

- Lügen aufzudecken, durch die kombinierte Analyse von verbalen Äußerungen und Gesichtsausdrücken,

- Stärken und Schwächen des Sprechers während zwischenmenschlicher Beziehungen auswählen.

Durch ein fokussiertes und interaktives Trainingsprogramm, das auf praktischen Übungen basiert, ist es möglich, in kurzer Zeit Techniken der nonverbalen Verhaltensanalyse zu erlernen.Die wissenschaftliche Grundlage

Der erste wissenschaftliche Text über emotionale Ausdrucksformen wurde von Guillaume Benjamin Amand Duchenne de Boulogne, einem französischen Neurologen, mit dem Titel “Mécanisme de la physionomie humaine, ou Analyse électro-physiologique de l’expression des passions applicable à la pratique des arts plastiques” verfasst. Der 1862 verfasste Text demonstriert die Methode des Anlegens von Elektroden an die Gesichtsmuskeln, um die Beziehung zwischen den Gesichtsbewegungen und den damit verbundenen emotionalen Ausdrücken herzustellen. Ihm zu Ehren wird das echte, authentische Lächeln heute das Duchenne-Lächeln genannt.

1872 schrieb Charles Darwin das Buch “The Expressions of the Emotions in Man and Animals”, in dem er darüber spekuliert, ob Emotionen ein evolutionäres Produkt seien und daher angeboren sind. Außerdem entsprechen die Gesichts- und Körperausdrücke diesen Emotionen und scheinen bei Menschen verschiedener Ethnien sowie bei Primaten und anderen Tieren gleich zu sein. Aufgrund der Feindseligkeit der wissenschaftlichen Gemeinschaft gegenüber Darwin und seinen Theorien wurden Darwins Studien zur Gesichtsausdrücke nach seinem Tod jedoch nicht fortgesetzt: Man kritisierte ihn dafür, dass er den Tieren Emotionen zugeschrieben hat, da Gefühle nach Ansicht seiner Kritiker nur Menschen gehören können; schließlich wirft man ihm vor, sich auf direkte Beobachtung zu stützen.

Das Konzept der Universalität grundlegender emotionaler Ausdrucksformen wurde Ende der 1950er Jahre erneut entdeckt. Bedeutende Forscher wie Friesen, Ellsworth, Ekman, Izard und Birdwhistell versuchten, Darwins Theorie zu bestätigen. Gemeinsam entwickelten sie eine Reihe von Theorien, Methoden und Tests, die in ihrer Gesamtheit das sogenannte “Facial Expression Program” bilden. Sie glaubten, dass der Ursprung des emotionalen Ausdrucks und des emotionalen Erlebens eine genaue Anzahl von angeborenen neurologischen Programmen sei. Heute wissen wir, dass es für jede Emotion einen spezifischen Pfad gibt, der die Unveränderlichkeit der mit dieser Emotion verbundenen Mimik sicherstellt. Diese angeborenen und phylogenetisch vererbten neuronalen Programme führen zu adaptiven Reaktionen, die auf emotionale Familien zurückgeführt werden können. Gemäß der Evolutionstheorie, zu der diese Arbeiten gehören, haben Emotionen eine adaptive Funktion, die es dem Menschen erlaubt, durch eine unmittelbare Reaktion auf verschiedene Reize (interne, externe natürliche und/oder erlernte Reize) zu reagieren, um zu überleben.

Es gibt zwei Gruppen von Techniken der nonverbalen Analyse:

- Die Kodierungstechniken, die Gesichts- und Körperbewegungen beschreiben,

- die Dekodierungstechniken, die die Bewegungen interpretieren

Wissenschaftliche Analysetechniken des Gesichtsausdrucks

Interpretative System of Facial Expressions (ISFE)

Das Interpretative System der Gesichtsausdrücke (Interpretative System of Facial Expressions) wurde in 2013 von Jasna Legisa im NeuroComScience-Labor entwickelt. Es ist eine zusammenfassende Übersicht der Bedeutungen von Gesichtsbewegungen. Es besteht aus einer Reihe von Tabellen und Beschreibungen, die Gesichtsausdrücken entsprechen und die damit verbundenen Emotionen integrieren und ordnen. Die Informationen sind aus früheren Systemen und vorhandener Literatur zum Thema abgeleitet.

Neben primären und sekundären emotionalen Ausdrücken werden auch andere Gesichtszüge beschrieben: Manipulatoren, Illustratoren und Regulatoren. Nach Hjorstjo (1969), Izard (1979) und Ekman (1983) werden die emotionalen Ausdrücke in der sogenannten “großen Familien” gruppiert, in der jede “Familien” mehrere Gesichtsausdrücke umfasst, die trotz ihrer leichten Bedeutungsunterschiede dadurch vereint sind, dass sie die gleiche emotionale Zuordnung erhalten. Die Familie “Überraschung” umfasst zum Beispiel die echte Überraschung, die unechte Überraschung, die verärgerte Überraschung, die Ehrfurcht und so weiter.

Die ISFE-Tabellen ordnen die primären emotionalen Bewegungen in drei Kategorien ein:

- Kategorie 1 umfasst die muskulären Bewegungen, die zu einer bestimmten Emotion gehören,

- Kategorie 2 umfasst die Bewegungen, die zu einer oder mehreren primären Emotionen gehören können,

- Kategorie 3 umfasst kleinere emotionale Varianten, die zu mehreren Familien gehören können.

Diese Klassifizierungen erleichtern die Genauigkeit und Interpretation der gesamten Analyse.

Hjorstjo-Methode: Menschengesicht und Mimiksprache

1969 versuchte Hjorstjo, ein Anatomieprofessor an der Universität Lund in Schweden, zum ersten Mal spezifische Gesichtsbewegungen und ihre Bedeutungen systematisch nach acht Familien von Emotionen zu kategorisieren.

Sein Handbuch berichtet über die Kodierung und Dekodierung von Gesichtsausdrücken, die es erlauben, Kontraktionen der Gesichtsmuskeln, einzeln oder in Kombination, zu bestimmen. Keine seiner früheren Studien, die er mit Landis (1924), Frois-Wittman (1930) und Fulcher (1942) durchgeführt hatte, erzielte solch vollständige Ergebnisse.

Maximally Discriminative Coding System (MAX)

Se fin qui sono stati descritti gli strumenti di codifica il cui obiettivo è stato quello di descrivere tutti movimenti muscolari facciali, a prescindere dalla conoscenza del significato di tali azioni, in questo altro strumento vengono individuate solo le unità comportamentali dei movimenti a cui gli autori attribuiscono un significato. Il Maximally Discriminative Coding System (MAX), elaborato da Izard nel 1979, e l’AFFEX, predisposto nel 1983, che risulta essere una seconda versione del MAX, ad opera, oltre che di Izard, anche di Dougherty e Hembree, stabiliscono a priori le configurazioni facciali, etichettandole sulla base delle espressioni del volto tipiche delle emozioni di rabbia, tristezza, paura, interesse, gioia, sorpresa, dolore, disgusto, vergogna. In pratica, viene classificata un’espressione prototipica per ciascuna emozione. Le emozioni prese in considerazione sono disgusto, rabbia, sorpresa, paura, tristezza, gioia, interesse, dolore.

Emotion FACS (EMFACS) e Facial Action Coding System Affect Interpretation Dictionary (FACSAID)

Ekman und Friesen ordnen die Einheiten der FACS den Ausdrucksformen von sechs Gefühlsfamilien zu: Glück, Traurigkeit, Ekel, Wut, Überraschung und Angst.

Diese in den 1980er Jahren durchgeführte Studie wird Emotionales FACS (EMFACS) genannt. Seit 1994 arbeitet Hager in Ekmans Laboratorium und untersucht die automatischen computergestützten Techniken zur Erkennung von Gesichtsausdrücken. Es wurde eine Datenbank mit einer neuen Schnittstelle entwickelt, aus der das sogenannte FACS Affect Interpretation Dictionary oder FACSAID-System entstand.

Hanest

Im gleichen Jahr erschien auch die erste Version des Facial Action Coding System, das Hanest-Handbuch. Letzteres, 1978 von zwei französischen Wissenschaftlern (Ermiane & Gergerian) entwickelt, hat das gleiche Ziel wie FACS, nämlich die Beschreibung von Gesichtsbewegungen.

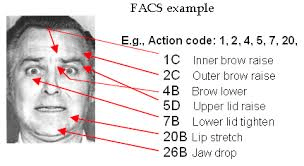

Facial Action Coding System

1978 führten Paul Ekman und Vincent W. Friesen das Facial Action Coding System (FACS, Gesichtsbewegungs-Kodierungssystem) ein und veröffentlichten 2002 in Zusammenarbeit mit Hager eine erweiterte Version. Es handelt sich um ein deskriptives Kodierungsverfahren zur Beschreibung von Gesichtsausdrücken und stellt eine detaillierte Beschreibung von Veränderungen aufgrund von Gesichtsbewegungen dar.

Baby Facial Action Coding System (BabyFACS)

Die gleiche Systemstruktur, die für Erwachsene verwendet wird, wird auch für Neugeborene und Kleinkinder verwendet. Oster (1993) berücksichtigte die Gesichtsbesonderheiten von Kleinkindern und passte die Beschreibungen entsprechend an. Das BabyFACS ist rein beschreibend und vermittelt keine emotionale Bedeutung.

Ein Beispiel für die Kodierung und Dekodierung von Gesichtsausdrücken

Einige grundlegende Bewegungseinheiten des Obergesichts

| 1 – Heben des inneren Teils der Augenbrauen |  |

| 2 – Heben des äußeren Teils der Augenbrauen |  |

| 4 – Absenken und Zusammenziehen der Augenbrauen |  |

| 5 – Weit geöffnete Augen |  |

| 6 – Hochziehen der Wangen |  |

| 7 – Spannung der Augenlider |  |

| Einige Kombinationsbeispiele des Obergesichts | |

| 1+2+4 (oder 3, je nach Kodierungstechniken). Diese Kombination entspricht dem prototypischen Ausdruck von ANGST. Keine andere primäre Emotion hat diese Kombination. |  |

| 4+5. Diese Sequenz gibt den prototypischen Ausdruck von WUT. |  |

Wissenschaftliche Techniken zur Gesten- und Haltungsanalyse

Körper-Kodierungssystem (Body Coding System)

Das Körper-Kodierungssystem ist das von Jasna Legisa entwickelte System zur Kodierung und Dekodierung gestischer und posturaler motorischer Verhaltensweisen für die Analyse der nonverbalen Kommunikation. Es analysiert körperliche nonverbale Verhaltensäußerungen und zerlegt sie in Handlungseinheiten. Letztere werden klassifiziert, um ein vollständiges Bild über den emotionalen Zustand der Person zu erhalten. Sie basiert auf der Beobachtung winziger körperlicher Veränderungen aufgrund muskulärer Aktivitäten. Diese Technik entstand aus der Notwendigkeit heraus, Fragen zu beantworten, die sich aus bestehenden Verbindungen zwischen körperlichen Äußerungen, emotionalen Erfahrungen und kommunikativen Prozessen ergeben.

- Die Ziele des Body Coding System sind:

- IMPLEMENTIERUNG einer strukturierten Methode der Gesten- und Haltungsanalyse,

- DEFINIEREN und Klassifizieren der Struktur der Bewegungen,

- ZUSCHREIBEN von Bewegungen und Haltungen zu ihren emotionalen, sprachbezogenen und kulturellen Bedeutungen.

Für die Verwendung des Body Coding System ist ein Zertifikat erforderlich. Für die Teilnahme an der Abschlussprüfung ist viel praktische Gesten- und Haltungsanalyse erforderlich: wer es lernt, sollte in der Lage sein, sich die körperlichen Aktionseinheiten perfekt zu merken und sie in kürzester Zeit zu erkennen.

Unser NCS-Team hilft und führt Sie durch den Lernprozess und steht für alle Fragen und Zweifel zur Verfügung.

Die Prüfungskommission setzt sich aus zwei oder mehr NeuroComScience BCS-Experten sowie aus Analytikern für emotionales Verhalten von Gesicht und Körper zusammen.

Das Kodierungssystem für Körperaktion und Körperhaltung

Das Kodierungssystem für Körperaktion und Körperhaltung (The Body Action and Posture coding system) (B.A.P.; Dael, N., Mortillaro, M., & Scherer, K.R., 2012) ist ein System zur Kodierung und Dekodierung gestischer und haltungsmotorischer Verhaltensweisen, das verschiedene Teile des Körpers berücksichtigt. Das Body Action and Posture Coding System untersucht hauptsächlich die Unterschiede in der Veränderung von Aktion und Haltung. Nach Ansicht der Autoren sind Handlungen getrennte Einheiten der Körperbewegung. Eine Aktionseinheit entspricht einer lokalen Abweichung eines oder mehrerer Artikulatoren (Kopf, Arm, Hand, Körperstamm), die sich von der vorherigen Konfiguration unterscheiden und die in die gleiche oder eine andere Position zurückkommen können (Schütteln des Kopfes, Geste des Zeigens mit dem Finger).

Im Gegensatz zu den Haltungseinheiten treten und wechseln die Aktionseinheiten häufiger auf, außerdem haben sie einen weichen Ausgangspunkt, eine relativ kurze Dauer und einen klaren Endpunkt. Diese Körperaktionen werden vom Kopf, den Schultern, den Armen (Ellbogen), den Beinen (Knie) ausgeführt und umfassen Aktionen wie das Senken des Kopfes, das Anheben der Schultern, Gesten, Kratzen, Treten und so weiter. Der Beginn einer Aktionseinheit ist ein vorübergehender Punkt, an dem die Versuchsperson die aktuelle Ruheposition ändert. Das Ende einer Aktionseinheit ist der zeitliche Punkt, an dem die Versuchsperson in eine Position zurückkehrt oder eine neue Ruhe- bzw. Ausgangsposition einnimmt.

Das Codierungssystem für Körperaktion und Körperhaltung unterteilt die Beschreibung in die Übergangs- und Konfigurationsphasen, die für die Realisierung einer Haltung immer korreliert sind. Der beginnende Übergang entspricht dem Beginn einer Bewegung, die notwendig ist, um die Endposition oder das Anfangsbild in einem Video zu erreichen. Der Übergang ist ein zeitlicher Punkt, an dem der in einer bestimmten Kategorie beschriebene Übergang abgeschlossen wird, oder er entspricht dem letzten Einzelbild in einem Video, wenn die kompromittierte Bewegung aus dem Video herausgeschnitten wird. Das Einzelbild ist der Beginn der Aufrechthaltung. Nicht jede Verhaltensänderung unterbricht eine eingenommene Position; es ist sogar möglich, dass eine bestimmte Körperposition auch nicht durch die Aktion eines anderen Körperteils unterbrochen wird. Zum Beispiel verändert das Kopfschütteln nicht die Position des Kopfes beim Nach-vorne-Kippen. Während der Konfigurationsphase wird die endgültige und kodifizierte Position der Person beibehaltet, jedoch bedeutet dies nicht, dass die erreichte Position statisch ist.

Im Kodierungssystem für Körperaktionen und Haltungen unterscheiden sich die Haltungen von den Aktionen:

- Die Haltungen sind weniger anfällig für häufige Veränderungen und haben folglich eine längere Dauer,

- die Haltungen sind fest (kleine Bewegungen verändern oder verzerren die Haltung nicht),

- vorausgesetzt, dass die Handlungen nicht immer gesehen werden können, befindet sich der Körper ständig in der einen oder anderen Haltung.

Das bedeutet, wenn ein Körperteil nicht an einer Handlung beteiligt ist, befindet er sich immer in einer bestimmten Haltung.

Ein Annotationsschema für Gesprächsgesten: Wie man Zeit und Form ökonomisch erfasst

Dies ist ein weiteres von Kipp et al. (2007) entwickeltes Kodierungssystem für das gestisch-motorische Verhalten. Ihr Ziel bestand darin, Anmerkungen zu den Gesten, die eine Person während eines Gesprächs tätigt, zu liefern, um eine universelle Erklärung dieser Bewegungen zu ermöglichen, auch wenn sie sich nur auf das Studium von Armen und Händen beschränkt. Gemessen werden hauptsächlich die Höhe, die Entfernung, die Art der radialen Orientierung sowie die Flugbahn der Arme und Hände. Keineswegs werden also alle komplexen Bewegungen, die der Körper ausführen kann, berücksichtigt.

Das System Neuroges (NGS) beschreibt Gesten in drei Modulen, wobei hauptsächlich auch die Bewegungen der Hände berücksichtigt werden:

- Kinesik der Gesten,

- relationale bimanuelle Kodierung,

- Kodierung der gestischen Funktionen.

Das erste Modul befasst sich mit den Merkmalen von Handbewegungen: Bewegung versus Nicht-Bewegung, Bewegungsbahn und ihre Dynamik oder ihr Fluss. Das zweite Modul bezieht sich auf die räumliche und funktionelle Beziehung zwischen zwei Händen. Das dritte Modul befasst sich mit der Funktion und Klassifizierung von Gesten.