Tecniche e metodi di Analisi del comportamento non verbale

Per svolgere un’analisi professionale del comportamento non verbale è fondamentale utilizzare tecniche che permettono di descrivere in maniera oggettiva il comportamento e attribuire ad esso un significato attendibile. I principali vantaggi riconosciuti dall’Analisi scientifica della comunicazione non verbale sono:

- Individuare con accuratezza le emozioni e gli stati d’animo altrui

- Anticipare i comportamenti della persona analizzata

- Identificare i punti di forza e debolezza nell’interlocutore e nella relazione interpersonale

- Smascherare le menzogne individuando le incongruenze tra il verbale e il non verbaleÈ possibile imparare le tecniche di analisi non verbale in poco tempo seguendo training mirati in cui viene utilizzata una didattica interattiva e basata sulle esercitazioni pratiche.

Le basi scientifiche

Un primo testo scientifico sulle espressioni emozionali è il libro del neurologo francese, Guillaume Benjamin Amand Duchenne de Boulogne, intitolato Mécanisme de la physionomie humaine, ou Analyse électro-physiologique de l’expression des passions applicable à la pratique des arts plastiques. Scritto nel 1862 riporta il metodo di applicare gli elettrodi alla muscolatura del volto per stabilire la relazione tra i movimenti facciali e le relative espressioni emozionali. Ancor oggi in onore dello studioso francese, il sorriso di gioia autentica viene definito come sorriso Duchenne.

Successivamente, nel 1872, Charles Darwin scrive il saggio L’espressione delle emozioni nell’uomo e negli altri animali nel quale ipotizza che le emozioni siano innate perché sono un prodotto dell’evoluzione. A tali emozioni corrispondono delle espressioni facciali e corporee che sono le stesse sia in uomini di diversa etnia sia in primati non umani o in altri animali. Gli studi sulle espressioni facciali di Darwin, però, non proseguono dopo la sua morte a causa dell’ostilità dell’ambiente scientifico nei confronti suoi e delle sue teorie; egli è infatti criticato per aver attribuito agli animali sentimenti che appartengono, secondo i suoi detrattori, solo agli umani e per essersi basato sull’osservazione diretta.

Le concezioni sull’universalità delle espressioni emozionali di base trovano particolare interesse dopo la metà degli anni ‘50. Ricercatori eminenti quali, per citarne alcuni, Friesen, Ellsworth, Ekman, Izard, Birdwhistell, cercano di dimostrarne la validità. Sviluppano un insieme di teorie, metodi e prove che, nella loro totalità, costituiscono il cosiddetto Programma Espressione Facciale. Questi studiosi ritengono che all’origine dell’espressione delle emozioni e dell’esperienza emozionale vi sia un preciso numero di programmi neurofisiologici innati. Esiste, quindi, un percorso specifico per ogni emozione che assicura l’invariabilità delle espressioni facciali, associate a ciascuna emozione. I programmi neuronali innati, ereditati filogeneticamente, danno luogo a risposte adattive riconducibili alle famiglie emozionali. Secondo la teoria evolutiva, in cui rientrano tali lavori, le emozioni hanno una funzione adattiva, permettono agli individui di reagire tramite una risposta immediata a stimoli interni, esterni, naturali o appresi, consentendo in questo modo di sopravvivere.

Le tecniche di analisi non verbale si distinguono in due gruppi:

- tecniche di codifica, la descrizione dei movimenti del volto e del corpo;

- tecniche di decodifica, che forniscono l’interpretazione del movimento.

Tecniche di Analisi scientifica delle espressioni del volto

Interpretative System of Facial Expressions (ISFE)

Con l’Interpretative System of Facial Expressions (ISFE) elaborato nel 2013 da Jasna Legisa nel Laboratorio NeuroComScience si ottiene una tavola sinottica per i significati dei movimenti facciali. Si tratta di una serie di tabelle e di descrizioni che integrano e ordinano le azioni del volto alle emozioni. Le indicazioni sono tratte dai sistemi precedenti e dalla letteratura esistente in materia.

Oltre alle espressioni delle emozioni primarie e secondarie, sono descritti anche altri segnali facciali: i manipolatori, gli illustratori e i regolatori. In primo luogo, le espressioni emozionali vengono raggruppate nelle cosiddette grandi famiglie come suggeriscono Hjorstjo (1969), Izard (1979) ed Ekman (1983). Ad ogni famiglia appartengono quindi più espressioni facciali che, nonostante le diverse sfumature del significato interpretativo, sono accomunate dal fatto di ricevere la stessa collocazione emozionale. Ad esempio, nella famiglia della sorpresa rientrano la sorpresa sincera, quella simulata, quella annoiata, lo sbalordimento, e così via.

Nelle tabelle ISFE i movimenti delle emozioni primarie sono stati distinti in 3 categorie:

- nella categoria 1 rientrano i movimenti muscolari che appartengono ad una categoria emozionale;

- nella categoria 2 vengono posti quei movimenti che possono appartenere a due o tre famiglie di emozioni primarie;

- nella categoria 3, infine, rientrano le varianti minori delle espressioni emozionali, vale a dire i movimenti che, potendo rientrare in molte famiglie emozionali. Tale distinzione in categorie facilita la precisione dell’interpretazione e di tutta l’analisi

Metodo di Hjortsjo: Man’s Face and Mimic Language

Si tratta della prima trattazione sistematica delle azioni specifiche dei muscoli facciali e dei relativi significati emozionali raggruppati in 8 famiglie di emozioni. È elaborata nel 1969 da Hjortsjo, docente di anatomia all’università svedese di Lund. Nel suo Manuale troviamo quindi la codifica delle espressioni facciali e la decodifica. Con esso è possibile determinare le contrazioni dei muscoli facciali, singolarmente o in combinazione. I principali studi precedenti a Hjortsjo sono svolti da Landis (1924), Frois-Wittman (1930) e Fulcher (1942) che risultano molto meno completi.

Maximally Discriminative Coding System (MAX)

Se fin qui sono stati descritti gli strumenti di codifica il cui obiettivo è stato quello di descrivere tutti movimenti muscolari facciali, a prescindere dalla conoscenza del significato di tali azioni, in questo altro strumento vengono individuate solo le unità comportamentali dei movimenti a cui gli autori attribuiscono un significato. Il Maximally Discriminative Coding System (MAX), elaborato da Izard nel 1979, e l’AFFEX, predisposto nel 1983, che risulta essere una seconda versione del MAX, ad opera, oltre che di Izard, anche di Dougherty e Hembree, stabiliscono a priori le configurazioni facciali, etichettandole sulla base delle espressioni del volto tipiche delle emozioni di rabbia, tristezza, paura, interesse, gioia, sorpresa, dolore, disgusto, vergogna. In pratica, viene classificata un’espressione prototipica per ciascuna emozione. Le emozioni prese in considerazione sono disgusto, rabbia, sorpresa, paura, tristezza, gioia, interesse, dolore.

Emotion FACS (EMFACS) e Facial Action Coding System Affect Interpretation Dictionary (FACSAID)

Ekman e Friesen delineano i significati interpretativi alle UA del FACS, descrivendo le espressioni di 6 famiglie di emozioni: gioia, tristezza, disgusto, rabbia, sorpresa e paura. Tale lavoro, svolto negli anni ’80, viene denominato Emotional FACS (EMFACS). Dal 1994 Hager lavora presso il laboratorio di Ekman e studia le tecniche di riconoscimento automatico computerizzato delle azioni facciali. E’ stato elaborato un database dotato di una nuova interfaccia, creando così il sistema chiamato FACS Affect Interpretation Dictionary o FACSAID.

Hanest

Nello stesso anno in cui esce la prima versione del Facial Action Coding System, 1978, esce anche il Manuale HANEST elaborato da due ricercatori francesi, Ermiane e Gergerian, che ha lo stesso scopo ovvero descrivere i movimenti facciali.

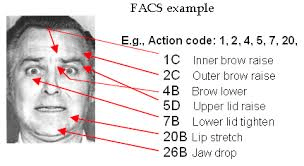

Facial Action Coding System

Nel 1978 Paul Ekman e Vincent W. Friesen introducono il Facial Action Coding System (FACS), nel 2002 esce la seconda versione con Joseph Hager. E’ un sistema descrittivo, quindi di codifica facciale, e quindi non attribuisce significati alle espressioni facciali. Si tratta di una descrizione minuziosa dei cambiamenti d’aspetto dovuti alle contrazioni facciali.

Baby Facial Action Coding System (BabyFACS)

Stessa struttura del sistema di codifica come per gli adulti, viene utilizzata specificamente ai neonati e ai bambini piccoli. Oster (1993) prende in considerazione le particolarità del volto e adegua le descrizioni. Il BabyFACS è puramente descrittivo dei cambiamenti d’aspetto dei movimenti facciali, senza attribuirne significati interpretativi.

Esempio semplice di configurazione di codifica e decodifica delle espressioni facciali (FOTO ESEMPIO)

Alcune Azioni di base del volto superiore

| 1 – innalzare la parte interna delle sopracciglia |  |

| 2 – innalzare la parte esterna delle sopracciglia |  |

| 4 – abbassamento e avvicinamento delle sopracciglia |  |

| 5 – sgranare gli occhi |  |

| 6 – guance innalzamente |  |

| 7 – tensione della palpebra |  |

| Alcune combinazione del volto superiore | |

| 1+2+4 (o 3, secondo alcune tecniche di codifica) Si tratta del prototipo della PAURA. In nessun altra emozione primaria si verifica tale combinazione. |  |

| 4+5 Prototipica per il volto superiore della rabbia. |  |

Tecniche di Analisi scientifica dei gesti e della postura

Body Coding System

È il sistema di codifica e decodifica del comportamento motorio gestuale e posturale per l’analisi della comunicazione non verbale, elaborato da Jasna Legisa. Il sistema di Body Coding System analizza le espressioni non verbali del corpo scomponendole nelle unità d’azione al fine di una classificazione che permette la lettura delle emozioni di una persona. Il Body Coding System si basa sull’osservazione dei cambiamenti momentanei d’aspetto del corpo dovuti all’attività muscolare. La tecnica per la misurazione del comportamento motorio gestuale e posturale è nata per rispondere ai quesiti riguardanti i legami esistenti tra le espressioni del corpo e l’esperienza emotiva e i processi comunicativi. Quindi gli obiettivi di Body Coding System sono:

- ADOTTARE un approccio strutturato di analisi del comportamento motorio gestuale e posturale

- DEFINIRE la struttura dei movimenti e la relativa classificazione

- ASSOCIARE i movimenti e le posture ai significati emozionali, di conversazione e culturali.

L’esame è una tappa fondamentale per l’utilizzo della tecnica Body Coding System e quindi essere certificati per poter applicare lo strumento. È consigliato prendere parte alla prova finale dopo aver fatto molta pratica nell’analisi del comportamento motorio gestuale, non è sufficiente infatti una lettura superficiale del manuale. Per superare l’esame è necessario avere una buona padronanza delle unità d’azione corporee e saperle riconoscere nel minor tempo possibile. Il nostro team, proprio per aiutarvi ed accompagnarvi nell’apprendimento, sarà sempre a disposizione per eventuali chiarimenti o dubbi.

La commissione d’esame che certifica la conoscenza del sistema di codifica motorio gestuale e posturale Body Coding System sarà composta da due o più esperti codificatori BCS ed Analisti del comportamento emozionale del volto e del corpo indicati dal laboratorio di analisi comportamentale di NeuroComScience.

The Body Action and Posture coding system

The Body Action and Posture coding system (B.A.P.; Dael, N., Mortillaro, M., & Scherer, 2012), è il sistema di codifica del comportamento motorio gestuale e posturale che considera varie parti del corpo. Il Body Action and Posture Coding System studia principalmente le differenze di cambiamento tra azione e postura, per gli autori le azioni sono unità del movimento del corpo divise che non sono una parte della classificazione del corpo. Un’unità d’azione del corpo è una deviazione locale di uno o di un gruppo di articolatori (testa, tronco, braccio, mano) al di fuori di una precedente configurazione di postura e ritorna sempre da quello o ad un’altra configurazione di postura. (ad es. scuotimento della testa, gesto di puntare un dito).

Al contrario delle unità di postura, le unità d’azione capitano e cambiano più frequentemente, e hanno un inizio molto discreto (punto d’inizio), una relativamente breve durata e un chiaro finale (punto di fine). Queste azioni corporee sono eseguite da testa, spalle tronco, braccia (gomito) e gambe (ginocchio) e coinvolgono attività quali abbassare la testa, alzare le spalle, gesticolare, graffiare, calciare, ecc. L’inizio di un’ unità d’azione è il punto temporale quando il soggetto cambia la corrente posizione di riposo. La fine di un’unità d’azione è il punto temporale quando il soggetto è tornato in una posizione (di riposo) (quella iniziale o una nuova posizione).

Il Body Action and Posture coding system suddivide la ricerca in Fase di transizione e fase di configurazione, e sono sempre correlate al raggiungimento di una postura. La transizione d’inizio è il punto di partenza del movimento necessario per raggiungere la posizione finale, o il fotogramma iniziale del video. La transizione è il punto temporale dove la transizione descritta in una particolare categoria è conclusa, o l’ultimo fotogramma del video se il movimento compromesso è tagliato dal video. Il fotogramma è codificato come l’inizio della configurazione della postura. Non tutte le azioni del comportamento interrompono una posizione in corso. Perciò è possibile che una posizione di una parte del corpo (ad es. la testa in avanti) non è spezzata dall’azione di un’altra parte del corpo (scuotimento laterale della testa). Durante la fase di configurazione la posizione finale del soggetto codificato è mantenuta per la direzione codificata. Ciò non implica che la postura ottenuta è statica.

Nel Body Action and Posture coding system le posture sono differenti dalle azioni perché:

- le posture sono meno soggette a frequenti cambiamenti e conseguentemente hanno durata più lunga;

- le posture sono robuste (piccoli movimenti non cambiano o distorcono la postura);

- considerato che le azioni possono o non possono essere mostrate, il corpo è continuamente in uno o in un altro allineamento posturale.

Questo significa che quando una parte del corpo non è coinvolta in un’azione, è sempre in una particolare postura.

An Annotation Scheme for Conversational Gestures: How to economically capture timing and form

Un altro sistema di codifica del motorio gestuale è stato elaborato da Kipp et al. (2007) descritto nel An Annotation Scheme for Conversational Gestures: How to economically capture timing and form (Kipp et al 2007). In quanto loro obiettivo è fornire buone annotazioni sui gesti che una persona fa, per chiarire il significato dei gesti che si fanno durante una conversazione, tentando di dare una spiegazione universale di questi movimenti, studiano principalmente braccia e mani e tralasciano tutto il resto del corpo. Svolgono una ricerca principalmente sulla misura dell’altezza, della distanza, il tipo di orientamento radiale, la traiettoria di braccia e mani, ma anche qui mancano i movimenti complessi e la descrizione di tutti i movimenti che possono essere eseguiti dal corpo. Neuroges (NGS) system descrive i gesti in 3 moduli, considerando soprattutto i movimenti delle mani:

- cinesica gestuale,

- codifica relazionale bimanuale e

- codifica delle funzioni gestuali.

Il primo modulo si riferisce alle caratteristiche dei movimenti delle mani: movimento verso non movimento, traiettoria del movimento, dinamicità (ovvero tempo, flusso). Il secondo modulo si riferisce alla relazione tra due mani, la relazione spaziale e la funzione relazionale. Il terzo modulo si riferisce alla funzione e alla classificazione dei gesti.

Scopri il calendario dei corsi seguendo questo link: https://lab-ncs.com/corso-facs-volto/